Perang AI yang tengah berlangsung di tahun 2023 ini tidak hanya melibatkan kompetisi dari sisi perangkat lunak saja. Perangkat keras atau hardware juga mendapat sorotan tersendiri di sini, tidak lain karena begitu besarnya daya komputasi yang dibutuhkan banyak sistem AI. Tidak jarang, mengembangkan chip sendiri yang dikhususkan untuk sistem AI pada akhirnya menjadi solusi bagi raksasa-raksasa teknologi yang bermain di ranah ini, salah satunya Meta.

Melalui sebuah posting blog, induk perusahaan Facebook dan Instagram itu menyingkap rencananya membangun infrastruktur di era serba AI. Rencana tersebut terdiri beberapa komponen, namun yang paling utama adalah sebuah chip khusus yang secara spesifik dikembangkan untuk mengakselerasi kinerja beragam sistem AI yang tengah dibangun Meta.

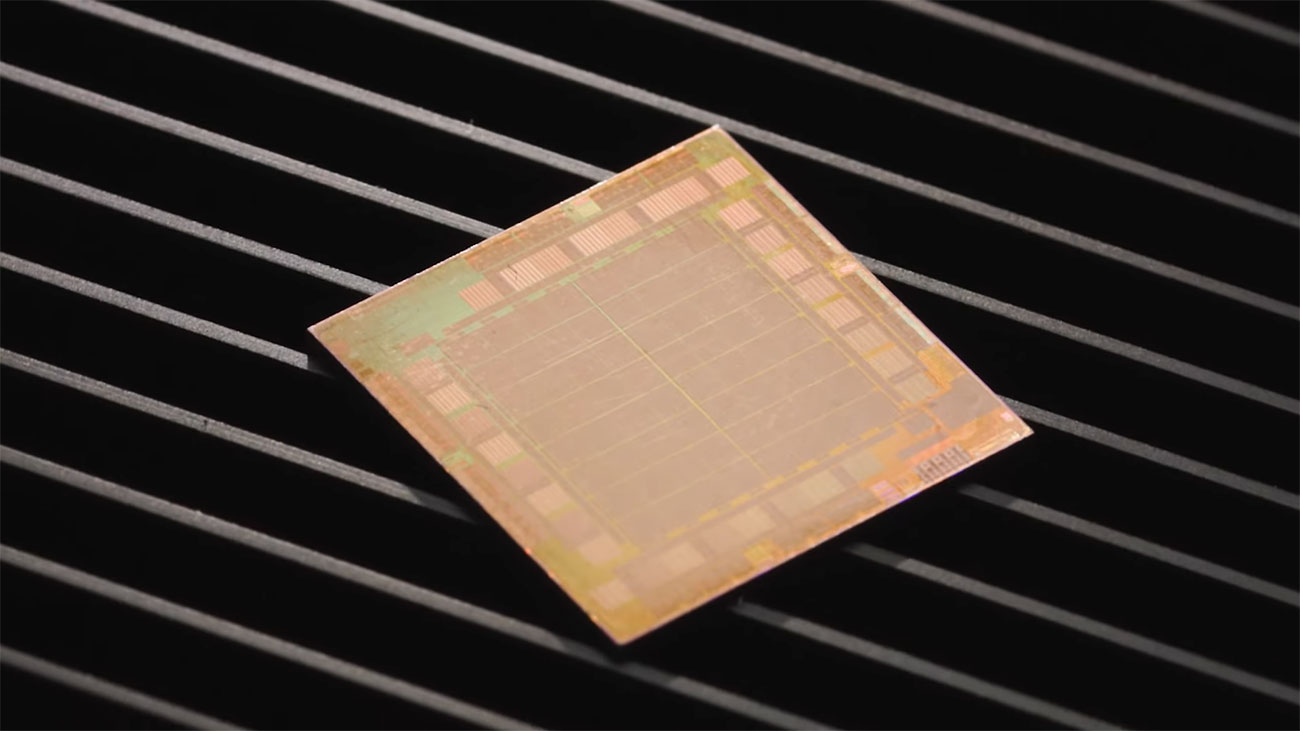

Meta Training and Inference Accelerator (MTIA), demikianlah Meta menamai chip AI bikinannya sendiri itu. Meta punya penjelasan teknis yang amat merinci mengenai MTIA, namun kalau mau disederhanakan, ini merupakan sebuah chip yang masuk dalam keluarga ASIC (Application-Specific Integrated Circuit), yakni jenis chip khusus yang menggabungkan beberapa sirkuit yang berbeda di dalam satu papan, yang kemudian dapat diprogram untuk menjalankan beberapa tugas sekaligus secara paralel.

Singkat cerita, chip MTIA dirancang agar sanggup menghasilkan daya komputasi yang lebih besar dan tingkat efisiensi yang lebih baik ketimbang sebuah CPU. Tim R&D Meta percaya bahwa dengan memadukan MTIA dan GPU, infrastruktur yang dibangun dapat menyajikan performa yang lebih mumpuni, latensi yang lebih rendah, dan efisiensi yang jauh lebih tinggi di setiap beban kerja.

Kepada TechCrunch, Alexis Bjorlin selaku VP of Infrastructure di Meta menjelaskan lebih detail mengenai alasan di balik keputusan timnya mengembangkan MTIA. “Untuk mendapatkan tingkat efisiensi dan performa yang lebih baik di seluruh beban kerja penting kami, kami membutuhkan solusi khusus yang dirancang bersama dengan model, software stack, dan perangkat keras sistem,” terang Alexis.

Dari CPU ke GPU, dan sekarang MTIA

AI bukanlah mainan baru buat Meta. TechCrunch melaporkan bahwa selama sekitar satu dekade, Meta telah menghabiskan miliaran dolar untuk merekrut sederet ilmuwan top dan membangun beraneka ragam sistem AI, termasuk yang sekarang menenagai discovery engine, filter moderasi, maupun mesin rekomendasi iklan yang bisa kita jumpai di produk-produk Meta.

Namun terlepas dari itu semua, Meta seakan kesulitan menyulap berbagai riset inovatifnya di bidang AI menjadi produk yang fungsional. Hal ini semakin terasa ketika tren generative AI mulai marak tahun lalu. Di saat popularitas ChatGPT terus melambung dan perusahaan seperti Microsoft maupun Google sudah merilis produk generative AI-nya ke publik, Meta sejauh ini baru punya tools generative AI untuk para pemasang iklan saja.

Usut punya usut, salah satu alasan Meta terkesan lamban di bidang revolusi AI bisa kita temukan di infrastruktur teknologinya. Hingga tahun lalu, Meta lebih banyak membebankan kinerja AI-nya ke perpaduan CPU konvensional dan accelerator chip yang mereka rancang sendiri. Problemnya, CPU bukanlah jenis chip yang cocok untuk tugas-tugas semacam ini, dan itulah mengapa perusahaan-perusahaan yang memiliki investasi besar di bidang AI lebih memilih untuk menggunakan GPU.

Meta akhirnya mengambil keputusan yang cukup berani. Mereka membatalkan rencananya untuk memproduksi custom chip tersebut secara massal, dan sebagai gantinya, mereka menggelontorkan miliaran dolar untuk membeli segudang GPU dari Nvidia.

Dalam upaya membalik keadaan, Meta kini punya rencana untuk mengembangkan sebuah custom chip yang lebih ambisius lagi, yang mampu melatih model AI dan menjalankannya sekaligus. Custom chip yang dimaksud adalah MTIA tadi, yang rencananya akan siap diproduksi secara massal pada tahun 2025.

Sejauh ini, Meta masih perlu mematangkan sejumlah aspek dari MTIA, utamanya memory dan networking. Kedua area tersebut diyakini masih menjadi titik lemah MTIA untuk sekarang, namun Meta percaya semuanya dapat dibenahi dan disempurnakan. Bukan kebetulan kalau Meta belum lama ini sempat mengakuisisi satu tim khusus yang sebelumnya bertanggung jawab atas pengembangan teknologi networking AI di produsen chip Graphcore.

Superkomputer AI untuk keperluan riset

Pembicaraan tentang AI tidak akan lengkap tanpa menyinggung soal superkomputer, sebab nyatanya daya komputasi yang diperlukan sistem-sistem AI memang semasif itu. Sejak tahun lalu, Meta telah memulai pembangunan superkomputer AI-nya sendiri yang diberi nama Research SuperCluster (RSC), dan di tahun 2023 ini, pembangunan fase keduanya disebut telah rampung.

Dalam wujudnya sekarang, RSC ditenagai oleh 2.000 sistem Nvidia DGX A100, yang jika ditotal mengemas 16.000 GPU Nvidia A100. Di atas kertas, RSC dipercaya mampu menghasilkan daya komputasi sebesar 5 exaflop — bukan yang tercepat memang, tapi masih sangat ideal untuk mengakselerasi berbagai eksperimen dan proyek riset AI yang dijalankan oleh Meta.

Sebagai contoh, Meta menggunakan RSC untuk melatih LLaMA (Large Language Model Meta AI), model bahasa ciptaannya sendiri yang belum lama ini sempat menjadi buah bibir setelah tim periset dari Stanford University berhasil membangun pesaing ChatGPT menggunakan model terkecil LLaMA.

Dua model terbesar LLaMA, yakni LLaMA 65B dan LLaMA 33B, dilatih menggunakan total 1,4 triliun token. Proses pelatihannya disebut hanya memakan waktu selama 21 hari menggunakan 2.048 GPU Nvidia A100 — bisa secepat itu meski hanya memanfaatkan sekitar 1/8 dari total kapasitas yang RSC miliki saat ini.

Ke depannya, waktu yang dibutuhkan untuk melatih model AI semestinya bisa dipangkas lebih jauh lagi, terutama ketika Meta sudah siap mengoperasikan chip MTIA tadi pada datacenter-nya.

Chip khusus untuk keperluan video transcoding

Meta bukanlah satu-satunya raksasa teknologi yang sedang sibuk mengembangkan chip AI-nya sendiri. Perusahaan seperti Amazon, Google, dan Microsoft juga tengah disibukkan oleh proyek custom chip khusus AI-nya masing-masing. Namun Meta rupanya tidak ingin berhenti sampai di situ saja.

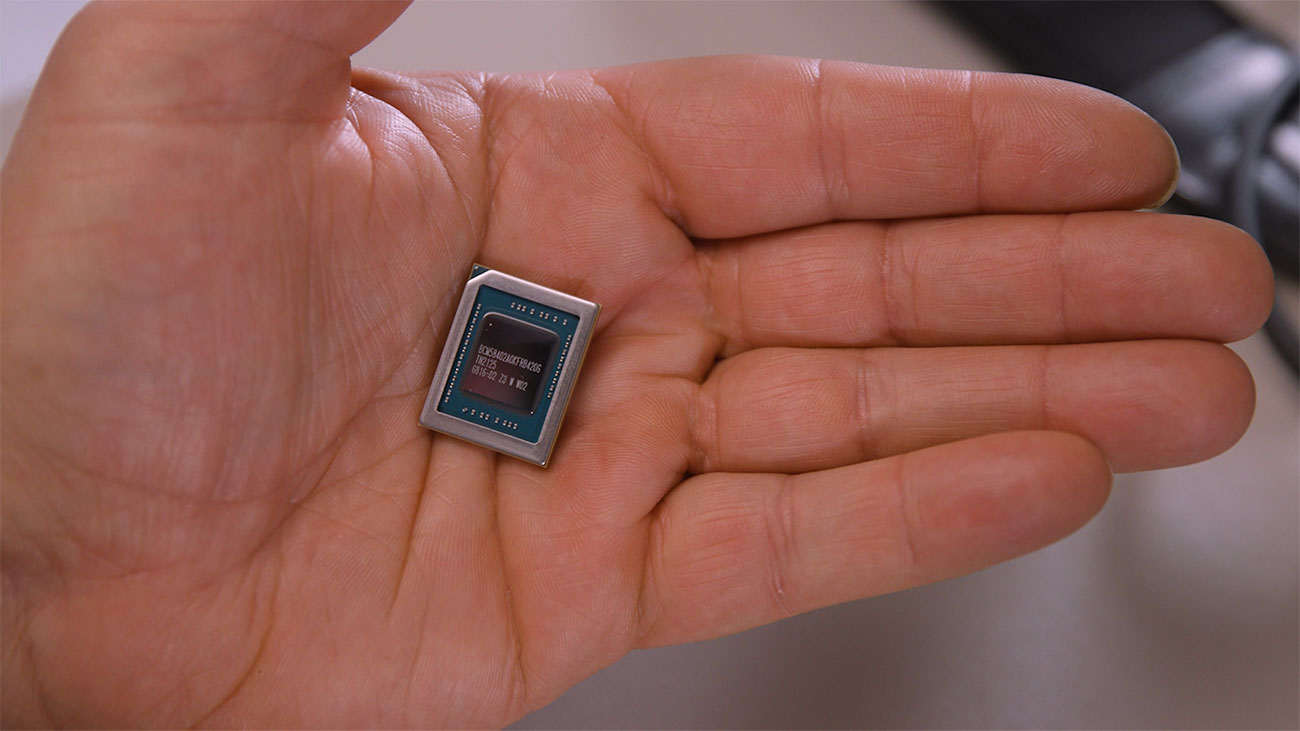

Di samping MTIA, Meta ternyata juga telah mempersiapkan satu custom chip lain yang tak kalah menarik, yaitu Meta Scalable Video Processor (MSVP). Sesuai namanya, chip ini dirancang khusus untuk keperluan video transcoding dengan memanfaatkan arsitektur ASIC. Yang menjadi pertanyaan tentu saja adalah, apa hubungannya AI dengan video?

Well, korelasinya bisa kita tarik dari tren generative AI itu sendiri. Selagi generative AI bertambah mainstream, maka konten yang diproduksi oleh AI bakal jadi lebih banyak lagi. Menurut Meta, semua konten yang dibuat generative AI itu pasti bakal butuh di-encode dan tidak akan berkeliaran di internet dalam wujud mentahnya begitu saja.

Di saat yang sama, MSVP juga sangat pas untuk bisnis Meta secara keseluruhan, yang memang banyak melibatkan konten video, entah itu di Facebook ataupun di Instagram. Dengan adanya MSVP, Meta berharap dapat meningkatkan efisiensi teknologi kompresi videonya, menekan konsumsi bandwith selagi masih mempertahankan — atau bahkan meningkatkan — kualitas konten video yang disajikan ke pengguna.

Secara keseluruhan, Meta melihat potensi MSVP untuk menjadi fondasi atas bermacam konten yang berseliweran di platformnya, entah itu video pendek, konten generative AI, konten AR/VR, maupun konten metaverse. Ya, Meta belum sepenuhnya lupa akan tren metaverse, meski ambisi barunya di ranah AI mungkin membuat kita berasumsi demikian.

Gambar header: Muhammad Asyfaul via Unsplash.