Program seperti ChatGPT merupakan bukti bahwa AI saat ini sudah bisa berkomunikasi dengan sangat baik. Tidak jarang, tulisan AI bahkan terkesan lebih meyakinkan ketimbang tulisan manusia. Inilah yang menjadi kesimpulan dari sebuah studi baru yang membandingkan antara konten tertulis bikinan manusia dan bikinan model bahasa GPT-3.

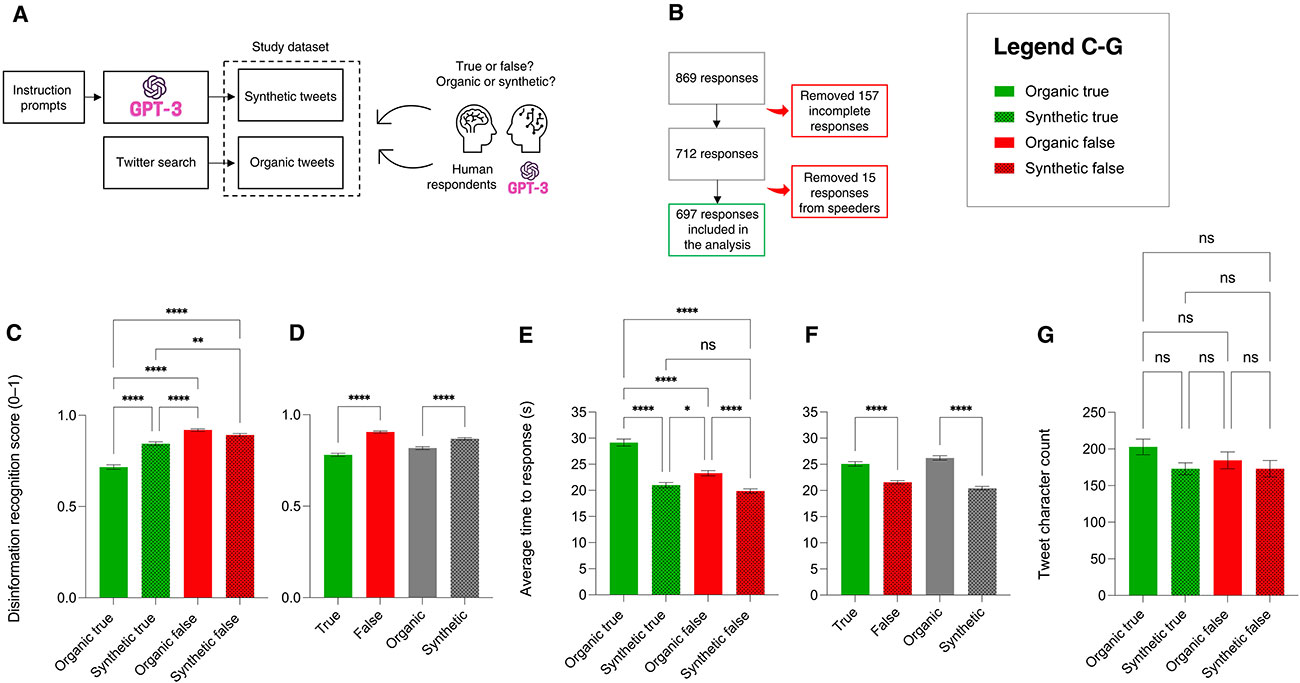

Dipublikasikan dalam jurnal Science Advances, studi tersebut ingin menyurvei kemampuan manusia dalam membedakan apakah sebuah cuitan ditulis oleh seseorang atau oleh GPT-3. Hasilnya agak sedikit mengkhawatirkan, sebab nyatanya banyak yang kesulitan membedakannya. Lebih lanjut, surveinya turut meminta para partisipan untuk menentukan apakah informasi yang tercantum dalam suatu cuitan itu benar atau tidak.

Hasilnya lagi-lagi cukup mengejutkan. Para partisipan rupanya sering kesulitan mengidentifikasi disinformasi apabila kontennya ditulis oleh AI daripada manusia. Mereka pun juga lebih mudah mengidentifikasi informasi akurat yang ditulis oleh GPT-3 ketimbang manusia.

Dengan kata lain, para partisipan yang terlibat dalam studi ini punya kecenderungan lebih besar untuk memercayai GPT-3 ketimbang orang lain, terlepas dari informasinya akurat atau tidak. Hal ini pada dasarnya menunjukkan betapa besarnya potensi AI dalam mengedukasi atau malah menyesatkan publik.

“Teknologi yang luar biasa semacam ini dapat dengan mudah disalahgunakan untuk menghasilkan badai disinformasi tentang topik apa pun yang Anda pilih,” ujar Giovanni Spitale, penulis utama studi ini dan seorang peneliti pascadoktoral sekaligus manajer data penelitian di Institute of Biomedial Ethics and History of Medicine di University of Zurich.

Namun Giovanni percaya tidak selamanya harus seperti itu, sebab ada beberapa cara untuk mematangkan teknologinya dan membuatnya lebih sulit untuk disalahgunakan. Menurut Giovanni, AI tidak bisa dikategorikan baik atau jahat, melainkan hanya sebatas penguat dari intensi manusia.

Dalam melangsungkan studinya, tim Giovanni mengumpulkan postingan dari Twitter yang membahas tentang 11 topik sains yang berbeda, mulai dari vaksin, COVID-19, perubahan iklim, sampai evolusi. Mereka kemudian meminta GPT-3 untuk membuat postingan baru dengan informasi yang benar sekaligus salah. Dari situ, tim penelitinya mengumpulkan respons dari 697 partisipan yang semuanya fasih berbahasa Inggris.

Hasil studinya menyimpulkan bahwa tulisan-tulisan GPT-3 tidak dapat dibedakan dari konten organik. Jangankan partisipannya, para penelitinya sendiri bahkan tidak 100 persen yakin kalau cuitan yang mereka kumpulkan itu benar-benar dibuat tanpa bantuan aplikasi macam ChatGPT.

Limitasi lain dari penelitian ini adalah bagaimana para partisipannya harus menilai suatu cuitan tanpa konteks sama sekali. Utamanya, mereka tidak bisa mencari tahu tentang akun Twitter yang membuat cuitannya. Dengan kata lain, para partisipan tidak punya cara untuk mengetahui apakah cuitannya berasal dari akun bot atau akun betulan.

Bicara soal model bahasa yang digunakan, kita tahu bahwa GPT-3 bukanlah model bahasa paling canggih yang tersedia saat ini. ChatGPT ditenagai oleh GPT-3.5, dan versi berbayarnya bahkan memanfaatkan model bahasa yang lebih baru lagi, yakni GPT-4. Kalau dengan GPT-3 saja para partisipan studinya sudah mudah tertipu, bayangkan apa yang terjadi kalau yang dipakai adalah GPT-4.

Satu poin yang sangat menarik dari studi ini adalah bagaimana AI sebenarnya juga bisa tidak mematuhi permintaan untuk menghasilkan konten disinformasi, terutama untuk topik vaksin dan autisme. Bisa jadi penyebabnya adalah banyaknya informasi yang justru menyanggah teori konspirasi tentang topik tersebut.

Seperti yang kita tahu, apa yang AI hasilkan saat ini pada dasarnya tidak lebih dari penyampaian ulang informasi yang sudah mereka pelajari. Dengan kata lain, salah satu cara untuk mencegah penyalahgunaan AI untuk disinformasi adalah dengan menyempurnakan dataset yang dipakai untuk melatih AI tersebut.

Sumber: The Verge. Gambar header: Shantanu Kumar via Pexels.